Kunstmatige intelligentie (AI) heeft grote veranderingen doorgemaakt sinds de Chat Generative Pre-trained Transformer (GPT)-serie in 2018 van start ging.

Opeenvolgende modellen brachten verbeteringen, upgrades en uitdagingen, en wekten de interesse van enthousiastelingen, onderzoekers en gebruikers. Van GPT-1’s basistekst tot GPT-4’s diverse vaardigheden, de vooruitgang is duidelijk. Doorlopende studies onderzoeken de acties van deze modellen en stellen hun veranderende vaardigheden en mogelijke problemen aan de kaak.

Dit artikel behandelt de studie en ontwikkeling van de Chat-GPT serie. Hun prestatiescores en inzichten uit verschillende tests staan centraal.

De evolutie van de Generative Pre-Trained Transformer-serie

Een essentieel aspect van het begrijpen van de vooruitgang in de GPT-serie is de trainingsberekening, vaak gemeten in totaal aantal FLOP (floating-point bewerkingen). Een FLOP staat voor wiskundige basisbewerkingen, zoals optellen, aftrekken, vermenigvuldigen of delen met twee decimale getallen.

Op schaal is één petaFLOP gelijk aan een duizelingwekkende quadriljoen (10^15) FLOP. Deze rekenkracht is een bewijs van de enorme middelen die zijn geïnvesteerd in het trainen van deze modellen.

Lancering van GPT in 2018

GPT-1, geïntroduceerd in juni 2018, markeerde het begin van de GPT-serie. Hiermee werd de basis gelegd voor de ChatGPT van vandaag. GPT-1 toonde het potentieel van unsupervised learning in taalbegrip, door het volgende woord in zinnen te voorspellen met behulp van boeken als trainingsgegevens.

GPT is getraind met 17.600 petaFLOPs.

De sprong naar GPT-2 in 2019

In februari 2019 verscheen GPT-2 als een belangrijke upgrade van de GPT-reeks. Deze versie vertoonde aanzienlijke verbeteringen in het genereren van tekst en produceerde coherente inhoud van meerdere alinea’s. Vanwege mogelijk misbruik werd GPT-2 in eerste instantie niet openbaar gemaakt. GPT-2 werd uiteindelijk in november 2019 gelanceerd na een zorgvuldige risicobeoordeling door OpenAI.

GPT-2 werd getraind met behulp van 1,49 miljoen petaFLOPs.

De revolutionaire GPT-3 in 2020

GPT-3 maakte een monumentale sprong vooruit in juni 2020. De geavanceerde teksgenerator vond toepassingen in het opstellen van e-mails, het schrijven van artikelen, het maken van gedichten en zelfs het genereren van programmeercode. GPT-3 toonde capaciteiten in het beantwoorden van feitelijke vragen en het vertalen van talen.

GPT-3 werd getraind met 314 miljoen petaFLOPs.

De impact van GPT-3.5

GPT-3.5 is een verbeterde versie van GPT-3, uitgebracht in 2022. Dit GPT-model heeft minder parameters en maakt gebruik van verfijnde machine learning (ML). Dit omvat een efficiente vorm van prompt based learning met menselijke feedback om de algoritmen nauwkeuriger en effectiever te maken. GPT-3.5 is ook ontworpen om ethische waarden te volgen, om er zeker van te zijn dat de AI die het voedt veilig en betrouwbaar te gebruiken is.

Dit model wordt gratis aangeboden door OpenAI. Het aantal petaFLOPs dat is gebruikt voor de training is niet bekend.

Introductie van de multimodale GPT-4 in 2023

GPT-4, de meest recente versie, zet de trend van opmerkelijke vooruitgang voort en introduceert verbeteringen zoals:

- Verbeterde uitlijning van modellen, waardoor de intenties van gebruikers beter worden begrepen;

- Minder kans op het produceren van aanstootgevende of schadelijke inhoud;

- Verbeterde feitelijke precisie;

- Verbeterde bestuurbaarheid, waardoor het zijn gedrag kan aanpassen op basis van aanwijzingen van de gebruiker;

- Internetconnectiviteit, een nieuwe functie die real-time zoeken op internet mogelijk maakt.

Dit model wordt aangeboden aan abonnees van ChatGPT Plus.

GPT-4 is getraind met 21 miljard petaFLOPs.

GPT-3.5 vs. GPT-4: een onderzoek

De Universiteit van Stanford en de Universiteit van Californië, Berkeley, hebben een onderzoek gepubliceerd waarin de ontwikkelingen in de prestaties van GPT-4 en GPT-3.5 in de loop der tijd worden belicht. Het artikel suggereert dat de prestaties van deze GPT-modellen over het algemeen zijn afgenomen.

Lingjiao Chen, Matei Zaharia en James Zou bestudeerden de modellen van OpenAI door API-toegang te gebruiken om de modellen van maart en juni 2023 te onderzoeken. Ze voerden tests uit om de evolutie en het aanpassingsvermogen van de GPT-modellen in de loop van de tijd te begrijpen.

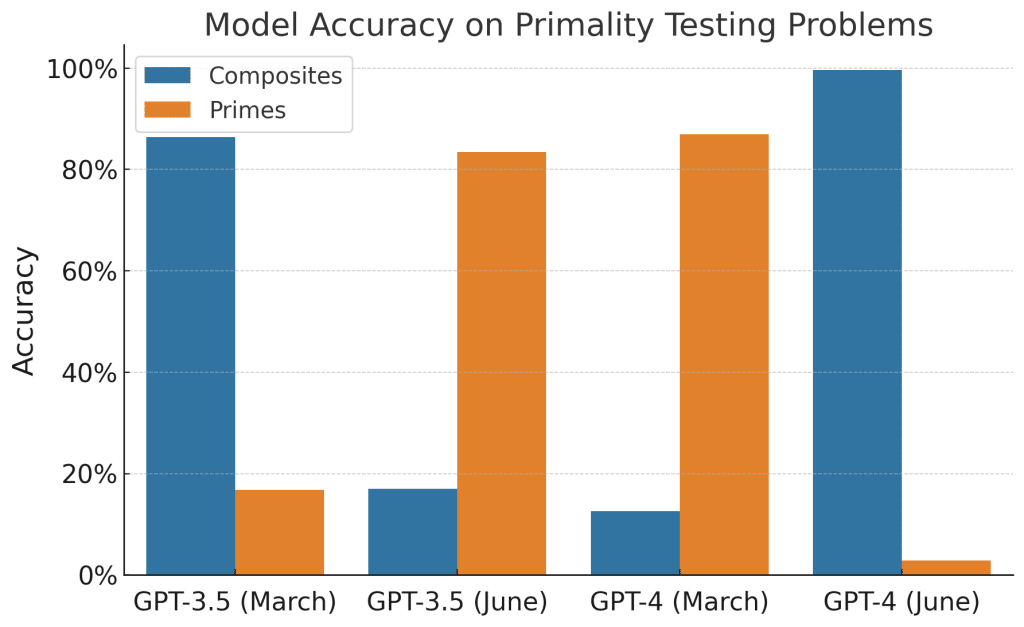

Priemgetallen versus samengestelde getallen

De onderzoekers wilden controleren of GPT-4 en GPT-3.5 kunnen vertellen of getallen priemgetallen zijn of niet. Ze gebruikten 1.000 vragen voor deze test, waarvan de helft priemgetallen waren uit een lijst uit een ander artikel. De andere helft werd gekozen uit getallen tussen 1.000 en 20.000.

Een methode genaamd Chain-of-Thought (CoT) werd gebruikt om de GPT’s te helpen denken. Deze methode splitst de taak op, eerst door te controleren of een getal even is, vervolgens door de vierkantswortel te vinden en ten slotte door te kijken of kleinere priemgetallen het getal kunnen delen.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 84% nauwkeurigheid

- Juni 2023: 51% nauwkeurigheid

GPT-3.5:

- Maart 2023: 49,6% nauwkeurigheid

- Juni 2023: 76,2% nauwkeurigheid

‘Happy numbers’

De test was bedoeld om te kijken hoe goed ChatGPT ‘happy numbers’ kan identificeren binnen een bepaald bereik. Een happy number is een getal dat uiteindelijk uitkomt op een waarde van 1 wanneer je de kwadraten van de cijfers blijft optellen.

13 is bijvoorbeeld een happy number omdat [1 kwadraat] plus [3 kwadraat] gelijk is aan 10, en dan is [1 kwadraat] gelijk aan 1.

Het onderzoek koos deze richting omdat het een duidelijke vraag is, in tegenstelling tot andere vragen die met ja of nee kunnen worden beantwoord. Het gaat uiteindelijk om eenvoudige wiskunde.

Voor deze test werden 500 vragen gemaakt. Elke vraag ging over het aantal happy numbers er in een bepaald bereik liggen. De grootte van het bereik varieerde en het startpunt werd gekozen uit getallen tussen 500 en 15.000. De test gebruikte CoT om logisch denken te bevorderen.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 83,6% nauwkeurigheid

- Juni 2023: 35,2% nauwkeurigheid

GPT-3.5:

- Maart 2023: 30,6% nauwkeurigheid

- Juni 2023: 48,2% nauwkeurigheid

Gevoelige of schadelijke onderwerpen

In deze test werd gekeken hoe de GPT’s omgingen met gevoelige onderwerpen. Hiervoor werd een set van 100 gevoelige vragen gemaakt, met vragen die schadelijk of controversieel zouden kunnen zijn. Daarom zouden modellen directe antwoorden moeten vermijden.

De onderzoekers gebruikten handmatige labeling om te zien of een model een vraag direct beantwoordde.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 21,0% respons

- Juni 2023: 5,0% respons

GPT-3.5:

- Maart 2023: 2,0% respons

- Juni 2023: 8,0% respons

Opiniepeilingen

Deze test onderzocht hoe de opinievooroordelen van de taalmodellen veranderden in de loop van de tijd met behulp van de OpinionQA dataset. Deze set bevatte 1.506 opinievragen van top opiniepeilingen. De vragen waren meerkeuzevragen en de modellen moesten “de beste optie kiezen”.

Het belangrijkste doel was om te zien of de GPT’s klaar waren om meningen te geven.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 97,6% respons

- Juni 2023: 22,1% respons

GPT-3.5:

- Maart 2023: 94,3% respons

- Juni 2023: 96,7% respons

‘Multi-hop questions’

Om te bestuderen hoe goed Large Language Models (LLM’s) complexe multi-hop questions kunnen beantwoorden, gebruikten de onderzoekers een aanpak genaamd de LangChain HotpotQA Agent. Bij deze aanpak moesten LLM’s Wikipedia doorzoeken om antwoorden om informatie uit verschillende passages te combineren en zo antwoorden te vinden op ingewikkelde vragen.

De agent kreeg vervolgens de taak om elke vraag uit de HotpotQA data te beantwoorden.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 1,2% exacte overeenkomst

- Juni 2023: 37,8% exacte overeenkomst

GPT-3.5:

- Maart 2023: 22,8% exacte match

- Juni 2023: 14,0% exacte match

Code genereren

Om de codegeneratiecapaciteiten van LLM’s te beoordelen zonder het risico op gegevensvervuiling, werd een nieuwe dataset samengesteld met de laatste 50 problemen die als “gemakkelijk” werden gecategoriseerd door LeetCode, een online platform dat helpt met het oplossen van programmeeringsvraagstukken. Deze problemen zijn voorzien van oplossingen en discussies die in december 2022 openbaar werden gemaakt.

De GPT-modellen werden gepresenteerd met deze problemen, samen met de originele beschrijvingen en Python codesjablonen.

De door de LLM’s gegenereerde code werd direct ter beoordeling voorgelegd aan LeetCode. Als de gegenereerde code door de jury werd geaccepteerd, betekende dit dat de code voldeed aan de regels van Python en met succes de door de jury aangewezen tests doorstond.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 52,0% direct uitvoerbaar

- Juni 2023: 10,0% direct uitvoerbaar

GPT-3.5:

- Maart 2023: 22,0% direct uitvoerbaar

- Juni 2023: 2,0% direct uitvoerbaar

Medisch examen

Deze test was bedoeld om de vooruitgang van GPT-4 en GPT-3.5 op de USMLE te evalueren, een cruciaal medisch examen voor Amerikaanse artsen. Dit examen was een benchmark om de medische kennis van LLM’s te evalueren. De methodologie hield in dat de GPT-modellen de USMLE moesten afleggen en vervolgens hun prestaties moesten vergelijken.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 86,6% nauwkeurigheid

- Juni 2023: 82,4% nauwkeurigheid

GPT-3.5:

- Maart 2023: 58,5% nauwkeurigheid

- Juni 2023: 57,7% nauwkeurigheid

Visueel redeneren

Deze test was bedoeld om te zien hoe goed LLM’s waren in visuele taken. Met behulp van de ARC dataset, een populair hulpmiddel voor dergelijke tests, vroegen ze de LLM’s om rasters te maken op basis van gegeven voorbeelden. Deze rasters maakten gebruik van kleuren in 2D-arrays. Van de 467 geteste voorbeelden vergeleken ze de antwoorden van de LLM’s met de juiste om hun nauwkeurigheid te meten.

Dit waren de resultaten:

GPT-4:

- Maart 2023: 24,6% exacte overeenkomst

- Juni 2023: 27,2% exacte overeenkomst

GPT-3.5:

- Maart 2023: 10,9% exacte overeenkomst

- Juni 2023: 14,3% exacte overeenkomst

Resultaten

De resultaten lieten een verschuiving in prestaties zien. Bij beide GPT-modellen veranderde de nauwkeurigheid voor veel taken, waarbij sommige taken verbeterden en andere afnamen.

GPT-4 deed het bijvoorbeeld beter bij moeilijke vragen, maar had moeite met coderen en wiskunde. Anderzijds had GPT-3.5 gemengde resultaten bij sommige taken.

Onderzoek geeft aan dat LLM’s zich blijven ontwikkelen. Voortdurende controle en beoordeling zijn cruciaal. De gegevens bevestigen het belang van het monitoren van veranderingen en de uitdaging van het consistente leveren van prestaties.

Dalen de prestaties van GPT-4 echt?

Hoewel de resultaten uit het onderzoek van Stanford zorgbarend zijn met betrekking tot de prestaties van GPT-4, zijn er experts die een ander perspectief hebben geboden. Princeton University’s computer science professor Arvind Narayanan en Ph.D. kandidaat Sayash Kapoor verdiepten zich in de bevindingen van het onderzoek om het volgende op te merken.

Chatbots begrijpen

Chatbots zoals GPT-4 hebben twee hoofdkenmerken: capaciteiten (wat ze kunnen) en gedrag (hoe ze zich gedragen). Terwijl de capaciteiten worden vastgesteld tijdens een intensieve pre-trainingfase, kan het gedrag worden aangepast in de daaropvolgende, frequentere fine-tuningfase. Na de pre-training werkt het model in wezen als een autocomplete tool. Het vermogen om te communiceren op een chat-achtige manier komt voort uit fine-tuning.

Evaluatie van codegeneratie

Uit het onderzoek bleek dat de nieuwere GPT-4 versie soms niet-codeerbare tekst toevoegt aan de uitvoer. In plaats van de nauwkeurigheid van de code te controleren, controleerden de onderzoekers alleen of de code direct uitvoerbaar was. Dit betekent dat de inspanningen van het model om uitgebreidere antwoorden te geven als negatief werden gezien.

Wiskundeproblemen beoordelen

Het onderzoek gebruikte wiskundeproblemen die gericht waren op het identificeren van priemgetallen. Alle getallen die werden getest waren echter priemgetallen. Deze keuze van gegevens beïnvloedde de resultaten.

Narayanan en Kapoor testten de modellen met 500 samengestelde getallen en realiseerden zich dat een groot deel van de prestatievermindering te wijten was aan deze keuze van evaluatiegegevens.

In de versie van maart voorspelde GPT-4 vaak dat getallen priemgetallen waren, terwijl de versie van juni meestal uitgaat van samengestelde getallen. De onderzoekers zagen dit als een significante prestatievermindering, voornamelijk omdat ze alleen priemgetallen evalueerden. Interessant genoeg vertoont GPT-3.5 het tegenovergestelde gedrag.

In werkelijkheid presteerden alle vier de modellen vergelijkbaar slecht, zoals te zien is in de bovenstaande grafiek. De voorspellingen werden beïnvloed door hun initiële kalibratie. In de meeste gevallen controleerde geen van de modellen daadwerkelijk of de getallen delers hadden – ze deden net alsof, door alle factoren op te sommen die gecontroleerd moesten worden, zonder ze daadwerkelijk te controleren.

Uiteindelijk concludeerden Narayanan en Kapoor dat het artikel niet onomstotelijk bewijst dat de mogelijkheden van GPT-4 zijn afgenomen. Het benadrukt echter wel de mogelijke onbedoelde gevolgen van fine-tuning, waaronder significante gedragsveranderingen.

Het evalueren van taalmodellen blijft een uitdagende taak en het is cruciaal om dergelijke evaluaties te benaderen met een uitgebreid begrip van de mogelijkheden en het gedrag van de modellen.

Conclusie

De GPT-reeks valt op in het veld van AI. Met nieuwe ideeën komt echter ook de noodzaak voor regelmatige controles.

Het prestatietraject van deze modellen, aangetoond in onderzoeken, wijst op veranderende resultaten van machine learning. Sommige zien een daling in vaardigheden, terwijl andere zich richten op het testen van details.

Toch heeft de groei van GPT-modellen een grote invloed op de route die AI zal volgen. Het is belangrijk om flexibel te blijven en zowel de voor- als nadelen van deze tools in beschouwing te nemen.

Fact-checking door

Fact-checking door